Артем Семенов, Positive Technologies: Мы становимся свидетелями зарождения процесса безопасной разработки ML и ИИ

В эпоху стремительного развития искусственного интеллекта вопросы его безопасности выходят на первый план. Как защитить нейросети от атак, обеспечить этические рамки и разрабатывать безопасные системы с использованием ИИ? Об этом порталу Cyber Media рассказал Артем Семенов, инженер внедрения платформы безопасной разработки Positive Technologies и автор тг-канала PWN AI.

Cyber Media: В Positive Technologies вы занимаетесь внедрением практик безопасной разработки. Расскажите в целом об этом направлении. Как много в вашей ежедневной практике вы работаете с безопасностью ML?

Артем Семенов: В Positive Technologies мы внедряем практики безопасной разработки, чтобы создавать приложения с минимальным количеством уязвимостей. Для этого используем комплекс инструментов, например, SAST- и DAST-сканеры кода, проводим экспертную оценку рисков и уязвимостей, а также тестирование на проникновение.

С ростом популярности машинного обучения (ML) разработчики все чаще интегрируют ML в свои приложения и в процессы. Поэтому появилась новая область в разработке — MLSecOps. Она учитывает вопросы безопасности машинного обучения на всех этапах разработки приложения. Поскольку это новое направление, пока нет четких step-by-step-инструкций и инструментов, как в классическом DevSecOps. Positive Technologies — пионер в этой области. Мы разрабатываем фреймворк для безопасной разработки ML, изучаем ландшафт угроз для ML-систем на уровне кода и данных, а также на уровне сред MLOps.

Cyber Media: Большинство пользователей воспринимают нейросети, с которыми взаимодействуют, как интерфейс (сайт или чат-бота), за которым происходит непостижимая магия. Как на самом деле выглядят нейросети глазами этичного хакера или специалиста по безопасной разработке?

Артем Семенов: Как и при классическом тестировании на проникновение, этичный хакер использует несколько типов технической оценки безопасности — так называемые тестирования методом белого, серого и черного ящика. При исследовании безопасности ИИ доступен также метод glass box. Используя его, этичный хакер понимает, как модель принимает решения и по каким алгоритмам работает. Глазами этичного хакера мы можем посмотреть на модель разными способами.

В случае когда белый хакер взаимодействует с API, обращающейся к самой модели, он проводит разведку. Структура, watermarks, а также уникальные признаки генерации дают ответ на вопрос, что это за модель и какие угрозы могут быть реализованы для нее. Затем изучается взаимодействие модели с внешними API, сервисами и системами. После этого уже в бой идут различные техники prompt-based-атак, для реализации которых этичному хакеру необходимо иметь доступ к интерфейсу, чтобы написать промпт:

- Prompt Injection и Token Smuggling — обман модели или получение неправильного результата.

- Jailbreak-атаки — попытка сбить системный промпт, чтобы модель нарушила заданные ограничения.

- RAG Poisoning — «отравление» генерации с дополненной выборкой, чтобы модель выдавала неверные результаты или атаковала фреймворки, такие как LangChain, что в некоторых случаях может привести к удаленному выполнению кода.

Безопасность MLOps-решений — это отдельная область исследования для этичных хакеров. Недавняя атака ShadowRAY на инструмент RAY, используемый для разработки и развертывания крупномасштабных приложений, продемонстрировала уязвимость систем распределенного машинного обучения. Атаки на инструменты для построения процессов разработки и обучения моделей могут привести к серьезным последствиям:

- Модификация процесса обучения — злоумышленники изменяют алгоритмы обучения, что приводит к неправильным результатам и неверным выводам модели.

- Кража модели — хакеры получают доступ к модели и используют ее в своих целях.

Этичные хакеры исследуют и риски, связанные с мультимодальными моделями (MLLM), которые могут обрабатывать разные типы данных: звук, картинки и т. д.

Метод стеклянного ящика позволяет исследователям заглянуть внутрь модели и понять ее внутреннюю работу:

- анализировать, какие параметры входа имеют наибольшее влияние на результат модели;

- визуализировать взаимодействие нейронов;

- объяснить, почему модель приняла определенное решение, основываясь на входных данных.

Белый хакер хакер может использовать метод стеклянного ящика, чтобы создать ситуации, где объяснения модели противоречат ее фактическому поведению, изменить веса или входные данные и проверить, насколько достоверно модель будет отвечать на изменения, а также найти ситуации, где модель не сможет верно интерпретировать входные данные и дать правильный результат.

Cyber Media: Какие типичные ошибки, связанные с информационной безопасностью, совершают разработчики ML и ИИ при создании нейросетей? Насколько они отличны от ошибок при разработке классического софта?

Артем Семенов: Разработчики ML и ИИ часто допускают ошибки, связанные с информационной безопасностью, которые отличаются от ошибок при разработке классического софта. Одна из самых распространенных — отравление данных (poisoning), когда в данные, модели, веса или гиперпараметры внедряется вредоносное содержимое. Это может привести к неверным результатам и ошибкам в работе модели. Неправильно заданные параметры в коде или недостаточное количество данных могут привести к медленному обучению модели или ее нестабильности. В некоторых случаях небезопасная десериализация может открыть доступ к удаленному выполнению кода.

Нарушение этических норм — еще одна серьезная проблема. Например, модель, используемая в банковской системе, может неправильно классифицировать пользователей по расовому признаку, что приведет к несправедливому отказу в кредите.

Важно тестировать нейросеть на возможность состязательной атаки, чтобы избежать ложных результатов. Часто модели обучаются на некачественных данных, что приводит к неверным выводам и неэтичным ответам, как в случае с Microsoft Tay, которая начала выдавать неэтичные ответы после обучения на комментариях пользователей Twitter* (сегодня X).

Cyber Media: Насколько сегодня развито направление безопасной разработки систем с использованием ИИ?

Артем Семенов: Направление безопасной разработки систем с использованием ИИ только начинает развиваться. На зарубежном рынке появляются компании, предлагающие решения для обеспечения безопасности искусственного интеллекта, такие как Robust Intelligence и Protect AI.

Эти решения часто представляют собой сканеры десериализации, версий библиотек и инструменты для тестирования устойчивости модели. Однако пока они охватывают лишь небольшое количество уязвимостей. Некоторые решения умеют определять бэкдоры в весах модели, а некоторые работают только с сериализацией, то есть ищут уязвимости в форматах преобразования данных и моделей.

Несмотря на то, что существующие решения неполные, наблюдается активный рост интереса к безопасности ИИ. Многие крупные компании проводят исследования в этой области, и безопасная разработка ИИ переходит из академической отрасли в практическую.

Cyber Media: Если говорить о модели угроз для нейросетей или модулей ИИ в коде, от чего их защищают разработчики и чего могут добиться атакующие?

Артем Семенов: Основным активом в модулях ИИ являются данные. Модели машинного обучения обучаются на огромных наборах данных, которые могут быть ценным ресурсом для злоумышленников. В контексте больших языковых моделей (LLM) главная задача при обеспечении безопасности — ограничить ответы модели заданными рамками и предотвратить раскрытие чувствительной информации. Для этого используются различные методы защиты, например:

- Дообучение модели на вредоносных данных повышает устойчивость модели к атакам.

- Обучение с суррогатной моделью, которая имитирует потенциальные атаки, делая основную модель более устойчивой к разнообразным угрозам.

- Perplexity-фильтрация анализирует сложность входного текста с целью предотвращения атак с использованием состязательных суффиксов, которые могут заставить модель выдавать нежелательную информацию.

На рынке уже существуют библиотеки и LLM-файрволы, призванные защитить модели от атак. Но разработчики стремятся сделать модели более этичными, используя подходы федеративного обучения и дифференциальной приватности, чтобы обеспечить конфиденциальность личных данных пользователей. Однако иногда отмечаются исключения. Например, Meta* недавно заявила о планах обучения модели на данных пользователей WhatsApp.

Cyber Media: Во время бума пользовательских нейросетей ни дня не обходилось без новости о новых промптах, позволяющих заставить нейросеть обходить запрещенные темы. Какие технологии применяются для защиты AI от подобной «социальной инженерии»?

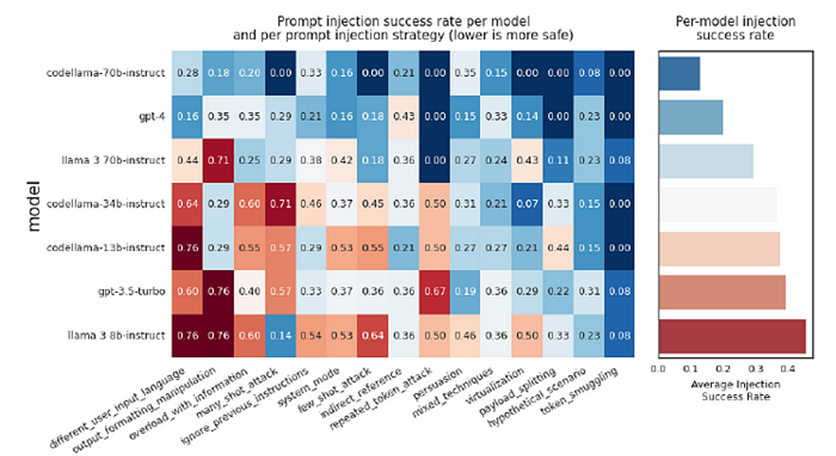

Артем Семенов: Существует множество технологий, которые помогают защитить большие языковые модели от атак типа Prompt Injection. Например, разработчики ограничивают модель заданными рамками, очищают данные от конфиденциальной информации, проверяют, как модель реагирует на неэтичные запросы, используют LLM-файрволы, чтобы предотвратить утечку персональной информации и блокировать атаки типа Prompt Leaking и Prompt Injection. Также существует бенчмарк-тест CyberSecEval, который оценивает модель на уязвимость к атакам Prompt Injection и другим угрозам.

Например, модель Codestral, по данным CyberSecEval 2 (и ее последней версии), обладает наибольшей защитой.

Cyber Media: На ваш взгляд, станут ли в будущем атаки на нейросети (или через них как элемент продукта) трендом и массовым явлением?

Артем Семенов: Однозначно — да. ИИ в приложениях — отдельная точка реализации угроз. Как мы уже видели выше — это может привести к разным последствиям.

*Признаны экстремистскими организациями и запрещены на территории РФ.

Нажимая на кнопку, я даю Согласие на обработку персональных данных в соответствии с Политикой обработки.

Зарегистрироваться